William Sealy Gosset 在一百多年前发明A/B测试的时候,他不知道自己无意中为百年后的互联网企业们创造了完美的测试手段。

William Sealy Gosset

A/B测试至少可以追溯到1908年,笔名为“Student”的 William Sealy Gosset 发明了 t-检验来确定 Guinness 用最好的大麦来酿造啤酒。他的方法允许对两组进行统计学上严格的比较,以确定它们之间是否存在显著差异。虽然这肯定有助于保持吉尼斯啤酒的高质量,但同时也创造了一个强大的工具,从音频工程师,到直邮营销人员,方便他们确定什么有效什么无效。

A/B测试在过去几十年里得到了真正的重视和应用。大多数公司都已经认识到,互联网是为A/B测试量身定制的:对应用和网站的更改快速方便,其影响可以轻松地通过点击和注册量化。

A/B测试已被用于测试从网站设计到免费送货优惠到内衣模特吸引力的一切。你最喜欢网站的工程师可能每天都会A/B测试这些网站的某些部分,那么你在网站上的行为对于他们来说就是一种数据。甚至还有专门的 Google Chrome 扩展程序,识别出你正在访问的网站的那些部分在做A/B测试。

一些企业发现,较小的设计更改,例如更改网站的背景颜色或按钮的大小,可能会显著影响客户行为。 Google 对其工具栏测试了41种不同的蓝色。虽然这可能看起来像是过犹不及,但对 Google 来说,点击率的小差异可能意味着大量美元。

一些A/B测试数据

在帮各种各样的企业在其网站上进行A/B测试的过程中, Experiment Engine 已经积累了大量关于人们如何使用这种统计测试的数据。 为了了解公司正在进行什么类型的测试,以及哪些测试显示出真正的影响,我们观察了由2014年底和2015年上半年进行的A/B测试组成的数据集。

我们发现最常见的A/B测试是设计更改(例如更改颜色或按钮的位置)和文本更改(例如测试按钮上方的不同文本)。 虽然设计更改是最常见的,但我们还发现,平均来说,它们对网站的影响比标题和文案内容要小一些。

当我们审查设计更改时,我们发现,对关键要素的位置和布局的调整,往往会产生最大的影响,特别是那些简化和流线型网站。

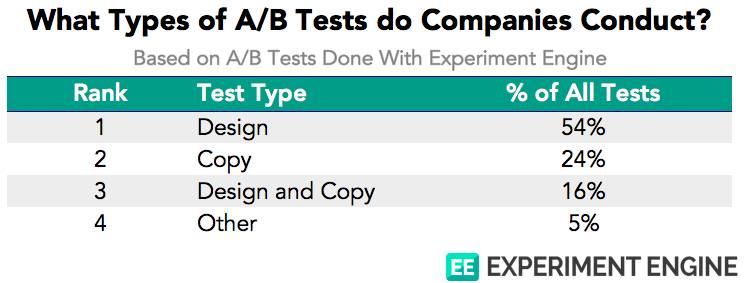

公司都会进行什么类型的A/B测试?

我们的客户进行两种主要类型的A/B测试:设计更改和文本更改。 文本更改会测试网站上的文字内容或短语,无论是标题,段落,甚至包括按钮上的“点击此处了解更多”之类的文字。

设计更改包括对页面的颜色方案和布局的更改,添加或删除图像和按钮等元素,以及更改页面的功能。

下表显示了最常见的A/B测试更改类型。

大多数测试涉及设计更改,但少数至少包括对网站文本的一些更改。 “其他”类别主要由政策更改,由免费送货优惠和退货政策更改组成。

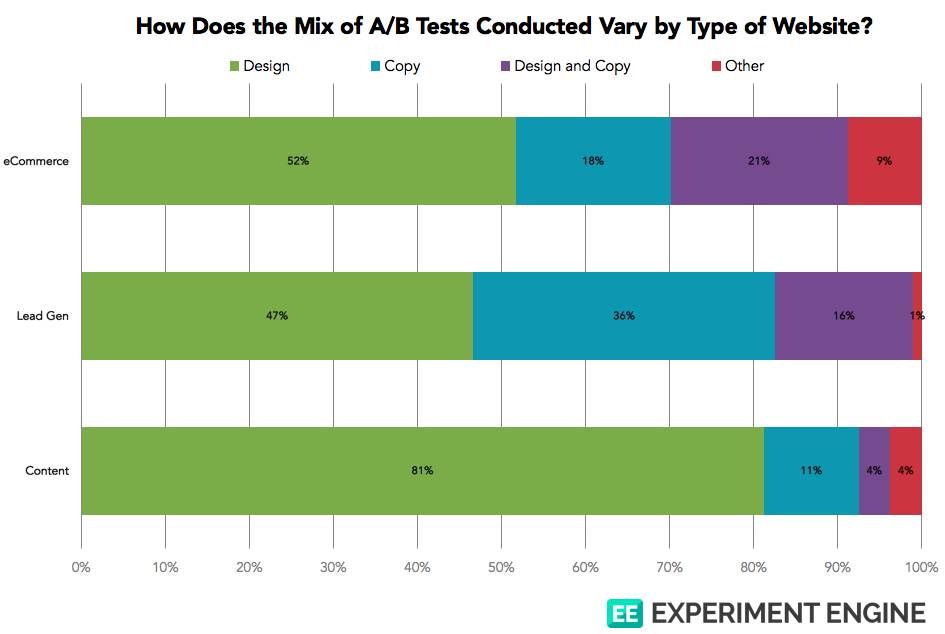

我们与各种网站合作,但大多数是电子商务,潜在客户开发或内容公司。 我们很好奇这些类型的网站之间的测试组合如何不同。

设计更改在所有类型的网站中占主导地位,但内容网站特别喜欢测试设计更改。也许这些以媒体为中心的网站对他们希望展示的具体内容充满信心,并且专注于寻找最具吸引力的展示方式。

潜在客户网站将客户联系信息销售给其他寻找销售线索的公司,这些网站极有可能专注于测试文本更改。可能是因为让用户输入他们的联系信息需要清晰的价值主张而不是有效的设计。

不同A/B测试的有效性

所以A/B测试实际有效吗?我们发现,所有A/B测试(我们现有的数据)的21.5%显示出统计显著的影响。虽然这看起来很低,但大多数与我们合作的公司会同时测试多个因素,因此大约有1/5显示出影响,实际上是相当不错的。

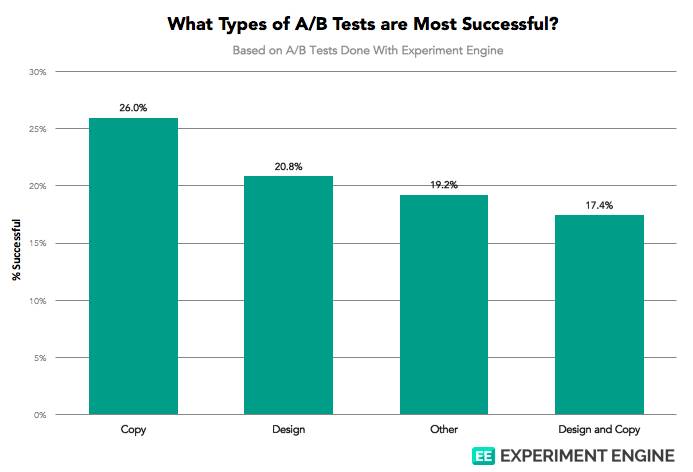

哪些类型的测试最常获得重要结果?下面的图表显示了每种类型A/B测试的成功率。

网站文本的更改成功率最高,为26%。 也许这是潜在客户开发网站正在做的试验。上面的数据也表明在单一的测试中同时更改设计和文本不是好主意。

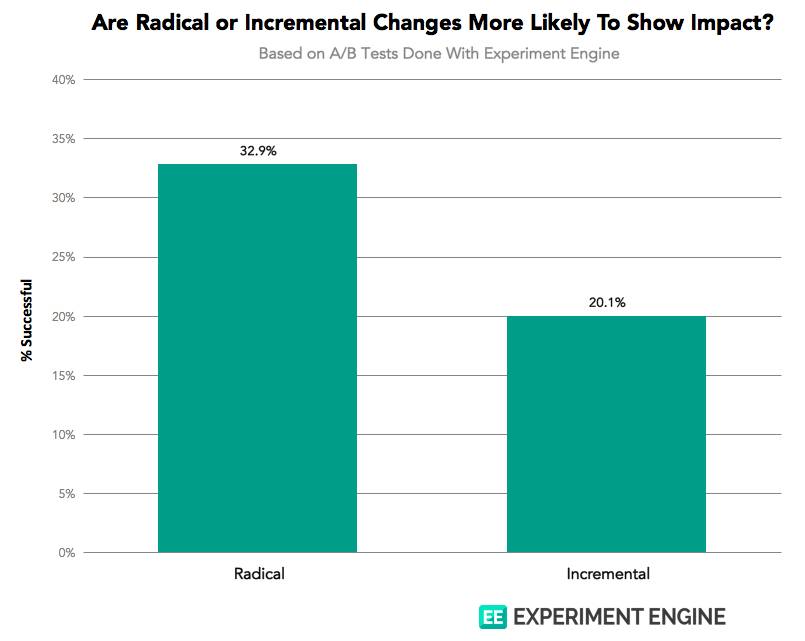

我们还想探讨增量变化(例如 Google 对41种蓝色的测试)或大刀阔斧的改革是否会产生更成功的测试。

显然,激进的改变往往更加成功。 这可能是因为他们更有可能在他们背后有一个明确的假设,而增量变化更具投机性。

当公司测试“设计”时,他们测试什么?

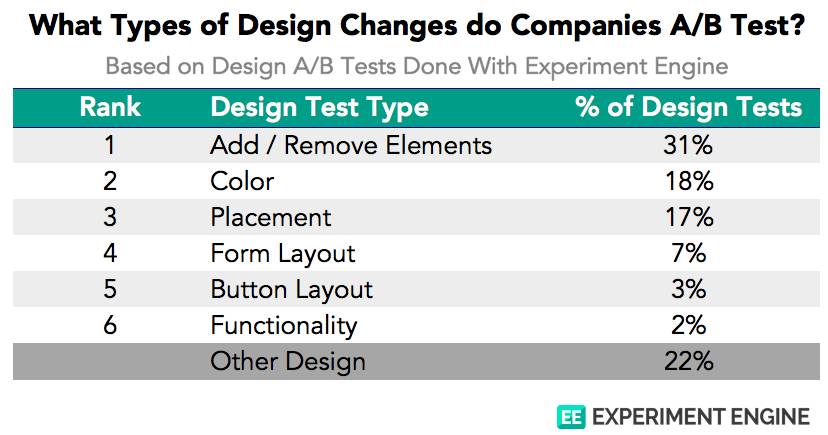

最后,由于我们客户的大部分A/B测试是设计变更,我们挖掘了公司正在进行的设计变更的确切类型。 下表显示了最常见的设计更改类别。

到目前为止,最常见的设计更改是添加或删除网站元素,如图片,横幅和标签。 颜色变化占所有设计变化的18%,而元素的位置变化也很常见。 对表单,按钮和网站功能的更改则很少。

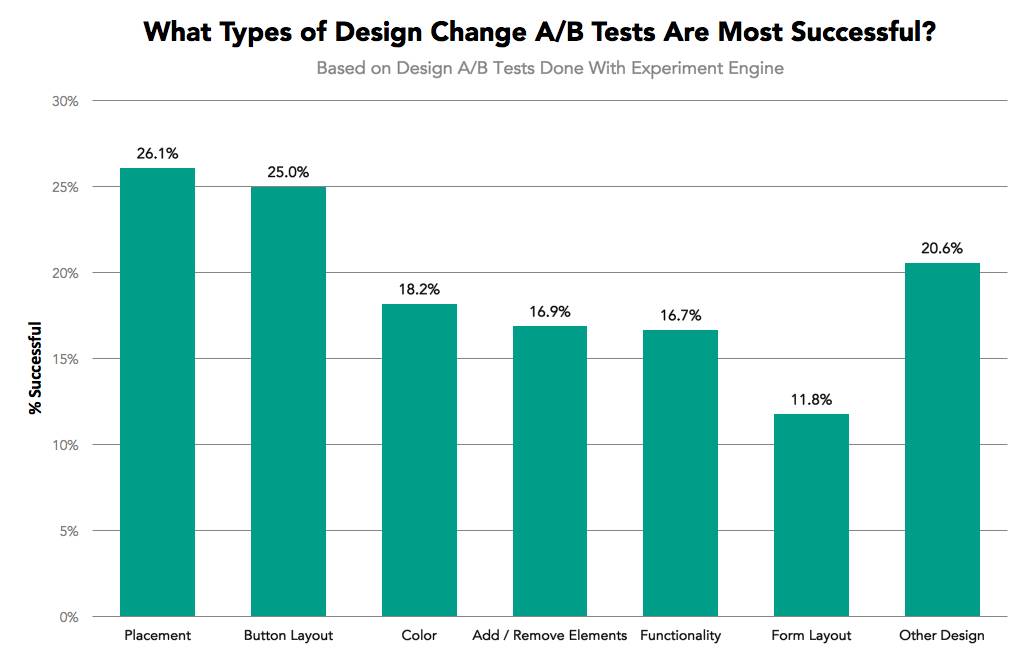

我们还检查了这些具体设计更改中哪些是最有效的。

位置和按钮布局是最有影响力的设计更改。这两个变化可能有助于访问者更有效地浏览网站,因此它们产生最大的结果并不奇怪。

对颜色,元素和功能的更改影响不大,成功率在17%左右。 对表单布局的更改(访问者在其中输入联系人信息)是最不成功的。 这可能是由于一旦用户决定填写表格,就不会被小设计问题劝阻。

好的设计有效

总的来说,数据表明A/B测试在测试网站文本和总体布局的相当激进的变化时是最有效的。设计更改侧重于优化元素的放置,精简用户体验可能会产生比调整颜色模式更好的结果。

作为一个网络用户,这是一个好消息。 当公司改你在网站上的体验并撰写清晰且引人注目的文本时,公司会看到最佳效果。 你可能更关心一个网站是否容易使用,而不管网站是否使用完美的蓝色。

本文由 Zoran @ 吆喝科技 翻译自:https://www.experimentengine.com/blog/2016/08/02/what-exactly-are-companies-ab-testing/

评论