编译 | 智东西 韦世玮

智东西8月19日消息,近日,谷歌开源了Android语音识别转录工具——Live Transcribe的语音引擎,源代码现在可以在GitHub上获得。

谷歌希望通过这一方式,能够让任何开发者为长篇对话提供字幕,进一步为安卓语音识别转录工具的实时转录功能提供动力。

一、两种转录方式,覆盖所有安卓设备

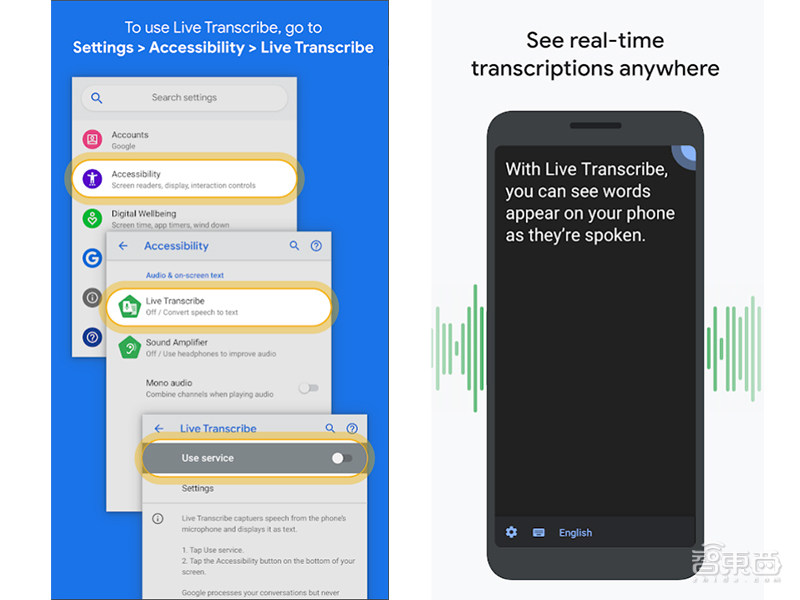

今年二月,谷歌发布了Live Transcribe,该工具通过使用机器学习算法,能将音频转换为实时字幕。

与谷歌即将为安卓推出的Live Caption(实时字幕)功能不同,Live Transcribe是一种全屏体验,它依赖于谷歌云Speech API(语音应用编程接口),能让用户通过智能手机的麦克风或外接麦克风使用。

Live Transcribe实质上是一种交流工具,一方面,它可以用70多种语言和方言来描述实时口语单词。另一方面,用户也可以通过输入文字来进行转录。

此外,Live Caption和Live Transcribe还有一个主要的区别。Live Transcribe可以在18亿台安卓设备上使用,而Live Caption只适用于部分Android Q设备。

二、如何解决云上工作的潜在弊端?

目前,谷歌的Cloud Speech API并不支持发送无限长的音频流。此外,它依赖云来使用的特性,也意味着它在网络连接、数据成本和延迟方面都有潜在问题。

因此,语音引擎会在请求超时之前关闭并重启,还会在长时间的静默期间重启会话,以及在检测到语音暂停时关闭会话。 在会话期间,语音引擎还会在本地缓冲音频,当网络重新连接时便可发送。

基于这些设计,谷歌避免了工具转录时会出现截断的句子或单词,并减少了对话中丢失的文本量。 为了降低带宽需求和成本,谷歌还评估了不同的音频编解码器,包括FLAC(无损音频编解码器)、AMR-WB(新型宽带语音编解码器)和Opus(有损音频编解码器)。

其中,FLAC可以保持转录的准确性,但不能保存太多的数据,并且具有明显的延迟;AMR-WB能够节省大量数据,但它在嘈杂环境中的转录不够精确;Opus允许使用比大多数音乐流服务还要低很多倍的数据速率,还能同时保留音频信号的重要细节。

此外,谷歌还可以在长时间的静音期间,通过语音检测来关闭网络连接。总体而言,谷歌能够在不影响转录准确性的情况下,将数据使用量减少10倍。

为了进一步降低延迟,Live Transcribe使用了自定义Opus编码器,能提高比特率,使延迟在视觉上无法区分发送但未压缩的音频。

三、Live Transcribe的9项语音引擎功能

谷歌列出了Live Transcribe的9项功能文档,但不包括说话人识别:

1、无限流媒体;

2、支持70多种语言;

3、当用户在网络和Wi-Fi之间切换时,可简化网络丢失。并且文字只会延迟,不会丢失;

4、对扩展网络丢失具有鲁棒性,即使网络中断数小时,仍会重新连接。但没有连接就无法进行语音识别;

5、可以轻松启用和配置Opus、AMR-WB和FLAC编码;

6、包含文本格式库,可用于可视化ASR(自动语音识别)置信度,发言人ID等;

7、可扩展到离线模式;

8、内置支持语音检测器,可在延长静音期间内用于停止ASR,以节省资金和数据;

9、内置支持扬声器识别,可用于根据扬声器编号标记或着色文本。

该文档还指出,这些库与生产应用程序Live Transcribe中运行的库几乎相同。谷歌已经对它们进行了广泛的现场测试和单元测试,但测试本身并不是开源的。

谷歌将为开发人员们提供APK(安卓安装包),让他们能够在不构建任何代码的情况下试用该库。

结语:为人们提供更高效和便利的沟通方式

谷歌表示,Live Transcribe是他们与加拉德特大学合作开发的一款应用,专为失聪和听障用户打造,而加拉德特大学是美国第一所专为失聪及听障人士设立的大学。

这款应用的开源对开发人员们来说,也许能进一步为失聪和听障患者的生活带来更大的便利。同时对普通人来说,也能帮助人们更快地适应各类新的语言环境,提供更高效的沟通方式。

文章来源:VentureBeat

评论