记者丨闫桂花

OpenAI“内斗”暂告一段落。自上周五首席执行官Sam Altman突然被董事会宣布遭解雇、董事长兼总裁Greg Brockman辞职;紧接着Altman据传将带领一队人马加入微软,到OpenAI员工以辞职威胁董事会要求Altman回归;再到本周三,OpenAI董事会更换成员、Altman回归OpenAI。表面上看,似乎是一场针对一家炙手可热独领风骚的技术初创公司控制权的争夺战,但本质上是人工智能(AI)发展两种路线的冲撞——一派扛着“加速主义”旗帜,希望AI在技术精英的带领下加速前进改造世界;另一边则是以利他主义理论为根基、力求让AI在人类控制下发展的保守派别。如果再深究下去,这是一场围绕人类道德、资本主义和政治的博弈。

此时此刻OpenAI以这种戏剧化的形式暴露在聚光灯下,或许意味着AI已经发展到了一个关键的岔路口,接下来的选择将关系到人类未来的福祉甚至存亡。到底该往哪儿走?

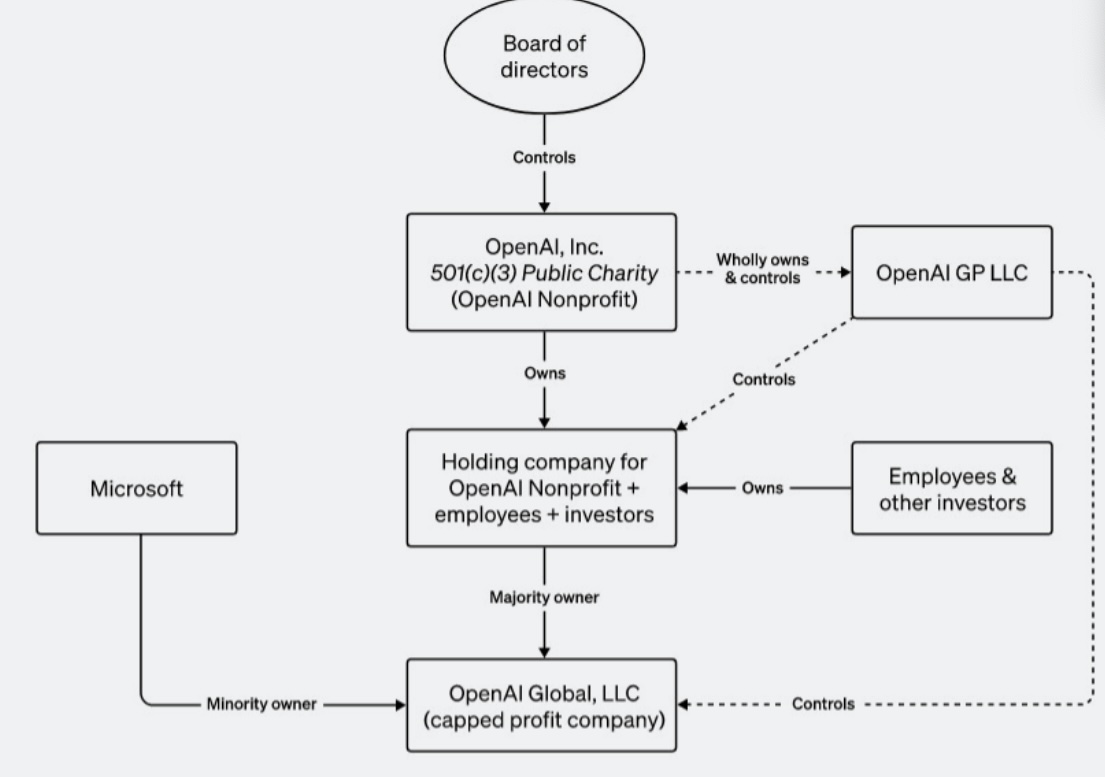

OpenAI之所以能逼走CEO,原因在于其独特的公司架构:最早由马斯克、Altman等联合成立的OpenAI是一个非盈利公司,即OpenAI Inc,最高权力为董事会;随后在2019年,Altman在OpenAI下成立了一个盈利性子公司,OpenAI LP(现在名Open AI Global LLC)获得微软注资,得以支撑其快速的发展。但OpenAI的董事会仍保留着对公司的控制权。

然而,随着ChatGPT的狂奔,以及由此引发的全球范围内的AI竞争,OpenAI似乎已经远离刚成立时的初衷,即打造以“为全人类服务”为宗旨的、安全可靠的通用人工智能(AGI)。

此时,有必要审视AI领域长期存在的两种对立的路线以及背后的哲学思潮。我们如何看待AI——是工具,是人类的伙伴,还是人类的驾驭者?以及,我们是否以及应该如何监管AI——是企业和行业自治,还是政府强力监管?甚至,人类是否会因AI灭亡?……

科技与人类的关系:“有效加速”(effective acceleration)vs “有效利他”(effective altruism)

加速主义萌芽于约20世纪初的未来主义运动。这一派别的追随者认为技术是一股强大、高速的力量,主张加快技术革命的速度,甚至对技术的毁灭性维度,如战争,都当作“美”来赞颂。2010年左右加速主义分成两个阵营并开始广泛传播,其中左翼认为需要改变现有的资本主义架构从而引导技术发展的方向;右翼则以哲学家Nick Land为代表,更强调资本的作用,认为技术和社会的领导权应由专制机构和少数技术人员掌握,后者被视为当下人工智能“有效加速主义”的哲学源头。

有效加速主义在硅谷拥有不少追捧者,比如在社交平台X(原推特)上,会发现有账号后面加有e/acc后缀(effective accelerationism的缩写),包括YC掌门人Garry Tan,A16Z创始人Marc Anderessen等。

他们对人工智能的看法如何?前阿里巴巴人工智能首席陶芳波有个简洁版的解释:

- 人类应该无条件地加速技术创新,并快速推出他们,来颠覆社会结构。

- e/acc 运动认为这种对社会的颠覆风险,本质上对人类有利,因为会迫使人类适应,从而帮助我们更快达到更高的意识水平。

- 过去三百年人类随着技术的颠覆而进化,结果显然都非常好。

与有效加速主义相对的是“有效利他主义”,警惕人工智能对人类可能带来的威胁。

有效利他主义大概始于十年前,发端于牛津大学的校园,最早只是活跃于互联网社区,最近几年势头凶猛,到如今已经发展成为遍布全世界的宗教般的庞大网络,拥有大量子分支和派别,成立了一系列的非营利机构、研究和预测中心、各种论坛等等,从比特币社区到美国白宫都有了其追随者身影,在硅谷更是有着大批拥泵。

有效利他主义有着一套复杂的全新的世界观体系,核心可以用哲学家Peter Singer的思想来概括,即“在维持基本生存以外你花的任何一笔钱,都是以另外一个人的死亡为代价”。该运动的领袖、牛津大学哲学系助理教授MacAskill将其进一步归纳为:如果有人因极度贫困而死去,就相当于你亲手杀死了他们。硅谷科技明星Elon Musk曾直言不讳地表示,MacAskill的理念“非常符合他的哲学观”。

最早这一运动主要关注全球贫困、动物福利,但最近几年,他们的焦点放在了人工智能对人类的威胁上。因为有效利他主义者认为,保护未来的人类,就跟保护现在的人类一样重要;而人工智能给人类带来了存在主义危机(existential crisis)。

显然,有效利他主义者对人工智能的态度更倾向于负面的、警惕的。著名计算机科学家、德克萨斯大学教授Scott Aaroson在他的个人博客里曾总结了极端的有效利他主义者是如何看待AI的:

- 人类的生存或毁灭取决于未来一两年内少数精英工程师的行动;

- 关于AI风险的公共宣传价值有限,因为大多数人无论如何都不可能理解;

- 人工智能会欺骗人类,同时努力摧毁人类,以令其效用函数最大化;

- 从看起来无害到在几小时或几年内密谋杀死所有人类,可能只需要一个门槛。

- ……

OpenAI的路线之争

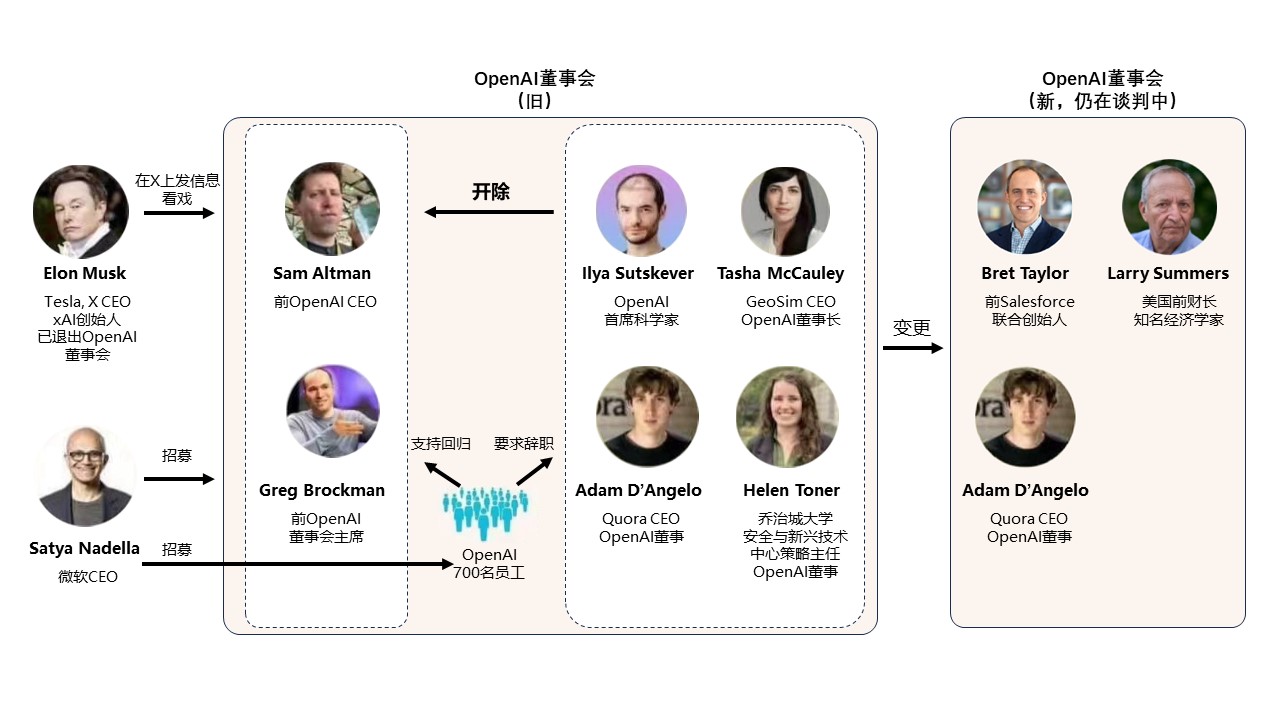

上周五之前,OpenAI最早董事会有6名成员,除首席执行官Sam Altman和董事长兼总裁Greg Brockman,还有Quora的首席执行官Adam D’Angelo、乔治敦大学Helen Toner、咨询公司Rand的兼职高级管理科学家Tasha McCauley,以及“AI之父” Geoffrey Hinton的学生、顶级人工智能科学家Ilya Sutskever,他也是OpenAI的联合创始人以及此次内斗的关键人物。

OpenAI成立初衷是非盈利组织,因此董事会并非利益驱动。据Venturebeat等多家媒体报道,Angelo,Toner和McCauley均隶属于有效利他主义阵营。2017年,OpenAI还曾获得了Open Philanthropy的3000万美元注资,而该项目是由有效利他资助的。OpenAI对此予以否认,表示这些非员工董事“与有效利他运动社区的互动主要集中在与AI安全相关的主题上,或者,提供为密切参与该团体的人员的观点。”

但至少Toner和McCauley与利他主义运动关系极其密切。两个人的名字经常出现在利他主义运动的论坛里,甚至McCauley的名字还赫然出现在由极端利他主义运动官方背书的主要成员名单上。俩人还一同担任英国国际人工智能治理中心的顾问委员会成员。

Toner 还曾在 Open Philanthropy工作,并且因与人合作的一篇文章中批评OpenAI 在发布 ChatGPT 时的安全实践不如其竞争对手 Anthropic,与Altman发生龃龉。在这篇论文中,她还提到,不能因为担心中国在AI竞争中后来居上而拒绝对AI的监管。

Toner频繁对外发声警告AI风险。今年5月,Toner警告不能过度依赖AI聊天工具,说其对人类来说“还有大量未知领域“,今年10月,她说美国政府应该“采取措施保护民众远离AI伤害和风险,与此同时提升创新、捕捉技术福祉”。

McCauley在公开舆论上并不活跃,鲜少就AI对外发表评论,可能部分因为她同时也是美国知名演员Joseph Gordon-Levitt的妻子。不过据她的X(原twitter)介绍,她是有效利他运动某个机构的英国董事会成员。另外据《纽约客》报道,她和她的丈夫与MacAskill是志同道合的好友。另外,同Elon Musk一样,她也是2017年阿西洛马人工智能原则(Asilomar AI Principles)的签署者。

至于Adam D’Angelo,他是否属于有效利他主义者仍然存在争议。不过从今年4月与Semafor的采访中可以看出,他更关注的是如何让AI与人类“对齐”,换句话说,人类应该怎样驾驭AI。他说这是他在OpenAI董事会的责任。“我不确定走到这一步是否是有风险,但让人们考虑这些问题是有用的。”但对AI他的态度比较乐观:“如果在某个节点上出现了超级强大的AI,那么另外一些人也会拥有超级强大的AI来保卫自己或者束缚AI或执行法律。”

作为OpenAI的技术灵魂人物,Ilya Sutskever显得非常低调,但他在公开场合无数次表达了对AI的担忧,用的是更深刻的、格言一般的表述方式:

他曾在X上发文,“如果你把智力看得比人类其他所有品质都重要,那么你的未来会很糟糕。”

他在接受英国《卫报》采访时,把AGI与人类的关系同人与动物的关系做类比。他说,人类不讨厌动物,还喜欢许多动物,但是当人类要造一条高速路时,不会向动物征求意见,因为高速路对人类很重要。“我认为,默认地,人类和通用人工智能的关系也将会是这样。通用人工智能完全自动,按照自己的意愿行事。”

今年10月,他接受MIT Technology Review采访时表示,他现在的首要任务不是要开发下一代GPT或者其他产品,而是如何阻止“人工超级智能作恶“。他还认为,ChatGPT可能是有意识的;世界需要睁开眼睛看看AI技术的真正实力,甚至,他预测未来有一天部分人类会选择与机器融为一体。“一种可能性——以今天的标准来看可能很疯狂,但以未来的标准来看不会那么疯狂——就是许多人会选择成为人工智能的一部分。”

在Altman被解雇前,Sutskever在X上发布的最后一条推文这样写道,“最终,AI 将变得非常、非常、非常强大。我们将无法理解他们。他们会比我们聪明得多。到那个时候,强烈的铭印至关重要,只有这样,他们对我们的感觉才会像我们对自己的孩子一样。”

出于对AI的担忧,今年7月,他与OpenAI的科学家同事Jan Leike(后者也被普遍认为是有效利他主义者)一起组建了一个团队,专注于他们所谓的“超级对齐”。超级对齐是OpenAI的术语,意即让人工智能模型做人类希望其做的事情。该项目计划利用OpenAI庞大计算资源的五分之一,在四年时间内实现科技突破,做到真正驾驭比人类聪明得多的AI系统。

那么,OpenAI此次内斗的核心人物Altman,他又是如何看待AI和AI风险? Altman负责创建了OpenAI的盈利子公司,并积极奔赴世界各地商讨融资事宜。与此同时,他是OpenAI的联合创始人之一,也是阿西洛马人工智能原则的签署人,在对外公开声明中也经常提及AI的风险并提议对AI进行适当的监管。他还是UBI(universal basic income)理念的积极倡导者。

以下是他在不同场合的一些公开发言:

- “如果AGI出了问题,没有任何掩体能帮助任何人。可怕的是,把这个杠杆放到这个世界上,肯定会产生不可预测的后果。“

- “我们能够管理好人工智能,我对此非常有信心。但如果我们对风险不是非常警惕,如果不坦率地谈论它可能会变得多么糟糕,我们就不会成功地管理它。”

- “我非常赞成资本主义。我认为这是迄今为止发明的最不坏的系统。所以我完全赞同人们从中获利。我只是认为这项技术的发展需要一个不同于普通的激励系统。”

- “人工智能将改变人们与世界互动的方式。从深层次上来说,人工智能是这个世界、也是人们一直想要的技术。科幻已经谈论人工智能许久了。”

但在业内人士看来,Altman是个伪装的利他主义者,实则是加速主义者。陶芳波给出了三个证据:

- 证据1:Garry Tan 作为 Sam 的接任者来执掌 YC,我很难想象他们不是一类人。以及有八卦说 Sam 被怀疑有小号来发表自己的加速主义立场。

- 证据2:这次 Sam 被驱逐,很多挂着 e/acc 的人已经把 Sam (Altman) 当做一个象征。从 GPTs 的仓促推出,对 Worldcoin 项目的大力投资,他是懂怎么“加速”的。

因此他认为,Altman的减速表象,是内部妥协,尤其是对Ilya Sutskever的妥协。

AGI——AI发展的关键节点

实际上我们很难武断地用“加速主义者“或者“利他主义者”的标签来定义OpenAI的前董事会成员,他们都看到了AI的潜能,也看到了AI的危害,只是在让AI达成何种程度的“对齐”上存在分歧,是应该加速还是踩刹车?如果踩刹车,踩到什么程度?

但他们背后的两种理念的拉扯,可能会影响到这些手握AI方向盘的少数几个人,在一个关键问题上的判断。这要回到OpenAI与微软的协议内容。

根据OpenAI的官方资料,微软从投资OpenAI子公司获得的收益是有上限的,不得超出其投资额度的100倍,而且,这些收益仅限于通用人工智能(AGI)达成之前,AGI达成之后则微软不能从中获得任何收益。OpenAI对AGI的定义是,“一个高度自治的系统,能在多数有经济价值的工作上超越人类”,但现实中如何判断是否达成AGI,则完全取决于OpenAI董事会的定义。也可以这样理解:AGI之前可以有限追求商业利益,在这之后需要为人类服务。

OpenAI“内斗”发生后,《纽约时报》曾援引三位OpenAI内部人士的话称,Ilya Sutskever越来越担心OpenAI的技术可能已经变得很危险,而Altman对此并未给予足够重视。

据路透社的最新报道,在Altman被罢免前几天,OpenAI几位研究人员曾致信董事会,警告他们发现了一种强大的AI技术,可能威胁人类。这项技术来自内部一个名叫Q*的项目,认为Q*已显示出接近人类的高级推理能力,可能意味着AGI出现了重大突破。

这让上周五Altman被罢免时,董事会给出的理由显得格外耐人寻味:先是表示Altman“在与董事会沟通时始终不够坦诚”,随后又补充说,这一决定与“与财务、业务、安全或安保/隐私实践相关的渎职”等都无关。

针对Altman为何被罢免的相关调查仍在继续。Altman是否隐瞒了OpenAI相关技术的发展?OpenAI是否达成了AGI?……更多真相或将浮出水面。

值得一提的是,OpenAI的两种路线之争并非此时才出现。早在2018年,Elon Musk退出他投资发起的OpenAI另起炉灶,就曾经表达对OpenAI越来越商业化的不满。《埃隆·马斯克传记》里提到他曾说过的一句话, “想想《2001:太空漫游》中大开杀戒的计算机‘哈尔’直接与创造它的人类开战。在人工智能系统中,人类可以设置哪些防火墙和自毁开关,让机器的行动与我们的利益保持一致?谁又有资格决定这些有关人类的利益是什么?”

OpenAI的内斗以Altman回归、董事会大换血而暂停。原先的董事会成员中除Angelo外,其他均离开,取而代之的是前Salesforce联合创始人Bret Taylor和美国前财长Larry Summers。

相比之前的董事会成员,这两位身上的“利他”色彩要淡得多。前者是AI技术领域的积极竞逐者;后者是硅谷科创领域的积极参与者。更值得关注的是,后者的政治人物身份,可能让围绕OpenAI和AI的路线之争,从道德和哲学伦理角度,更进一步扩展到了政治场域。也许,在这场事关世界大多数人未来但大多数人都无法参与的AI路线争夺战中,我们至少需要确保我们的注意力不要离场。

评论