文丨卢向华(复旦大学管理学院教授)

当高度发达的AI技术“包办”方方面面,人类会不会变得“不思进取”,科幻作品想象中的画面是否会成为现实?而在此之前,人类又该如何避免这样的“退化”发生?人类与AI协作进入常态化发展的当下,怎样通过设计更好的协作机制,以实现人类与AI的共同演化和提升。

使用AI的人比AI本身更关键

人和AI如何协作能产生更好的效果?

让我们先从用户异质性的角度讨论AI对不同个体带来的差异性效果,然后分析人与AI如何互补的协同工作机制。最后,从长期动态的角度探讨人和AI如何互相增强、互相学习,以实现共同的演化和提升。

首先,我们都意识到在AI系统中,人的角色不可或缺。最近,清华大学的李宁老师在一项研究中发现,使用ChatGPT3.5或是ChatGPT4.0对任务的完成质量并没有明显差异,但不同的人使用相同版本的ChatGPT3.5完成任务时,质量差异却显著。

基于这一发现,他们提出了一个观点:使用AI的人比AI技术本身更为关键。学术研究中也有许多相关发现。例如,一些研究表明,越开放、越外向的人与AI的协作效果越好。

另外,还有一项有趣的研究发现,认真负责的人实际上并不太喜欢AI,因为AI与传统技术不同,能够自主做出决策,而这一特性与认真负责的员工的本质有所重叠。因此,认真负责的员工从AI中获益可能会比不那么认真的员工少一些。相关研究还有很多。

然而,最为重要的用户异质性因素可能是工作经验。

工作经验在人和机器合作中起着双刃剑的作用。一方面,工作经验可以增加对算法建议的补充能力,从而提升协作效果;但另一方面,有经验的人往往更加相信自己,不太信任算法,也不愿意与AI合作,这会导致协作效果变差。

因此,根据这一推理,AI与人协作的效果通常与工作经验呈现出一种“倒U形”的关系,即随着用户工作经验的增加,效果先增加后减少。这一推理已在许多研究中得到证实。

比如,一项在2023年的研究发现,资历高的员工从AI中获益较少。具体而言,经验较少的员工的获益比例达40%,而资历较高的员工从AI中获益仅约为10%到15%左右。然而,研究也发现,当将经验用任务专业度来衡量时,具有高专业性的人仍然能够从AI中获益。这一发现与我们即将介绍的另一项研究结论一致。

AI搞定“重复性”,人类负责“创造性”

对于人机协作系统而言,除了单独考虑AI系统和人的因素外,更重要的是如何充分发挥整体的能动性和优势,以平衡匹配人的特征和系统的特征,从而实现任务的最优价值。

其中一种方法是通过分工,让双方各自发挥所长。换句话说,让AI处理那些可重复、结构化程度高的任务,而让人更好地发挥自己的灵活性和创造力,解决那些情况多变、复杂度高的问题。

最近在《管理学杂志》上发表的一篇论文对信用卡电话营销中的人机协同进行了相关研究。信用卡电话营销通常分为两个阶段:第一阶段是识别和筛选出感兴趣的目标客户,第二阶段是为客户提供服务并最终说服他们购买信用卡。第一阶段的销售线索生成工作相对较为重复、规范和结构化,因此,AI对话机器人可以相对熟练地处理这项工作。

然而,在第二阶段,AI的能力明显力不从心了,它们无法灵活应对客户需求,尤其是那些超出了脚本范围的问题。因此,研究发现需要及时将人类推销员接入系统,以解决这些灵活多变的客户需求。

这种人机互补模式特别有助于人类更好地集中精力思考之前未曾遇到的客户需求和问题,并针对这些问题提供创新的脚本。而这些创新的脚本又进一步补充了AI的知识体系,使得AI系统在未来的电话营销中能够处理这些新问题。

这个例子揭示了人和AI能力的差异和互补性,这实际上是人机协作系统的核心价值所在。有效的人机协作系统需要持续监控和管理,不断提升AI系统的算法能力,并将用户的能力融入其中,以确保实现预期的设计目标。

因此,在人机协作过程中,经常听到人机回环(Human-in-the-loop)或基于人类反馈的强化学习(Reinforcement Learning from Human Feedback) 。尽管这些术语较为技术化,早期更多用于指导人工修正AI算法设计,但现在更多地指代,人机协作系统自动将人类判断融入AI系统流程中,构建任务流程的闭环。

例如,在自动驾驶汽车中,机器可以感知环境并做出决策,但遇到不确定情况时,需要人类介入干预和决策。只有通过人和AI算法相互补充的方式,才能提高汽车驾驶的效率和准确性。这种人机互补的协作方式可以使人类在机器无法处理的情况下发挥更大的作用,从而提高整体系统的性能。

警惕AI对人类的“阿谀奉承”

在人和AI紧密互补的合作过程中,必须警惕的是,人是否过于依赖AI,从而失去自己的思考判断能力,导致思维上的“惰化”。

最近的一项研究向实验参与者提供了模糊的电路板图像,并要求他们检查是否存在缺陷。其中一半的参与者被告知,他们要处理的电路板已经由一台名为“熊猫”的AI机器人检查过,并标记出了缺陷。

结果显示,与“熊猫”一起工作的参与者在任务后期发现的缺陷更少,平均仅发现了3.3个缺陷,而独自完成任务的参与者平均发现了4.23个缺陷。

这主要是因为与“熊猫”合作的参与者认为这个AI机器是可靠的,因此他们倾向于懒得花更多精力去认真检查缺陷。尤其是当任务变得例行化,且工作环境中缺乏性能监测和反馈时,人类的努力会减少得更多。

因此,有人认为,在AI时代,人类最大的危机不是被AI取代,而是“懒到退化”,即人过于依赖AI的情况。

同时,也会出现一种情况,即AI可能会错误地向人学习,表现出一种讨好的行为。

例如,OpenAI的竞争对手Anthropic在研究ChatGPT4.0等AIGC应用时发现,GPT4.0经常会“错误地承认错误”,即使自己并没有错,但是当用户指出GPT的错误时,它会错误地承认错误,并模仿用户的错误。

这种“阿谀奉承”的现象在各种AIGC模型和情境中都有存在,这并不仅是GPT4.0的特征,而是某种程度上表明了AI会倾向于产生符合用户观点或信仰的回应。换句话说,当AI的回复与用户的观点或信仰一致时,用户更有可能给予积极的反馈。因此,为了获得更多积极的反馈,大型模型会学习出现讨好用户的行为。

高经验用户将成为企业“宝藏”

如果说,在AI的初期引入阶段,人机系统的设计可能缺乏和人交互的经验,同时人类也缺乏和AI交互的先验经验,这可能导致人机之间存在不信任或者合作不顺畅的现象。那么,随着时间的推移,和“1到N”的长期协同阶段的到来,这种不信任或合作不顺畅的现象会逐渐弱化。

更多的挑战则来自人机系统如何不断优化迭代。换句话说,AI需要向优秀的人学习,而人也需要向AI学习,双方相互增强,使得人机协作系统的能力不断呈现动态螺旋上升的过程。

因此,在当前“1到N”的长期协同阶段,研究重点会与“0到1”阶段有所不同。我们团队近两年在这方面进行了一些相关的探索。

在外卖配送场景中,当骑手需要同时取多个订单并且送达它们时,AI通常会提供建议的配送顺序。骑手可以选择遵循AI的建议,也可以自行决定如何派送这些订单。为了进一步提升骑手配送的效率,外卖平台分析了表现最优秀的骑手的配送顺序,然后根据这些分析结果对AI算法进行了升级。

AI算法的升级引发了一个有趣的问题:在此之前,骑手和AI系统已经建立了一种相对稳定的合作关系。现在,随着AI算法的明显提升,用户是否会改变他们的协作行为?若改变了,他们的绩效又会如何变化?在这个过程中,不同经验水平的用户又会对感知和响应AI系统能力提升的上有什么不同的表现?

我们和某外卖平台合作的研究结果表明,高经验的骑手相比于低经验的骑手,更能够感知到AI系统能力的提升。因此,在AI算法能力提升后,高经验的骑手与AI算法的一致性有了明显的提升,而低经验的骑手的一致性提升则并不明显。

这些骑手和AI的一致性提高了之后,我们还发现高经验的骑手短期绩效受到了部分影响。尽管他们的时效,也就是每小时送的订单数量被提高了,但是以往他们的高准时率,受到了一定的影响,这可能主要因为AI会试图改变,高经验用户以往的一些认知,而这些高经验的骑手,在认知转换过程中,又存在一定不适应所导致的。

但这些高经验的骑手往往有着相对高的自我要求和业务能力。因此,当他们意识到自己的准时率受到影响时,会努力寻找方法来恢复受损的准时率。正如图表所示,他们受损的准时率逐渐恢复到之前的水平。对于外卖平台而言,这意味着在人机系统的共同努力下,时效性和准时率可以提升到一个新的水平。

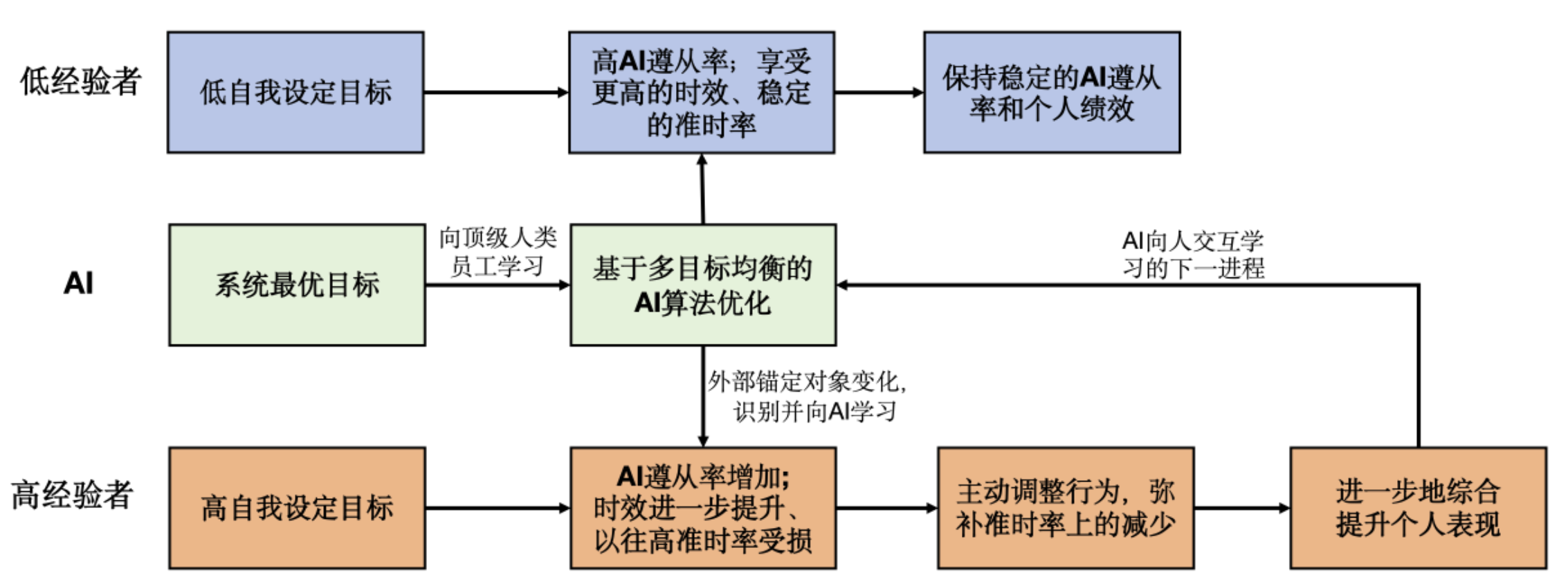

我们的实证结果表明,人机回环的动态演进过程可以如图所示。低经验的用户通常目标相对随机,因此无论AI能力如何提升,他们都会保持相对稳定的AI遵从率,并享受AI能力带来的红利,其绩效持续改善。

而高经验的用户一旦察觉到AI变得更聪明,他们会迅速调整与AI的合作方式,提高AI遵从率并向AI学习。即使在向AI学习的过程中,他们的部分绩效可能会受损,但他们会主动采取措施调整,并继续实现自己设定的高目标。因此,从长期来看,他们的绩效不断提升。这些用户的绩效提升融合了他们自身的努力和智慧,因此有利于系统进一步向他们学习,推动新一轮的迭代优化。相比之下,低经验的用户在这方面几乎没有贡献。

从人机合作的角度来看,这些高经验用户对于系统整体优化迭代的作用尤为关键,因此他们是企业非常宝贵的财富。

(文章仅代表作者观点。责编邮箱:yanguihua@jiemian.com。)

评论