2016年,世界上最优秀的围棋选手之一李世石(Lee Sedol)在首尔输掉了一场围棋比赛,而对手却是一个名为“AlphaGo”的计算机程序。无论是在围棋的历史上还是在人工智能的历史上这都成为了一件重大的事件。

围棋在中国、韩国和日本的文化中占有大致相同的重要地位,就像象棋在西方一样。在战胜李世石之后,AlphaGo在网上进行了一系列匿名游戏,打败了数十名著名的人类棋手。AlphaGo 接着在5月重新出现在中国乌镇,面对世界围棋排名最高的选手柯洁(Ke Jie)。柯洁的表现并没有胜于李世石,零比三输给了AlphaGo。

这并不是人类第一次完败给人工智能。

早在1997年,人类就已经在国际象棋比赛中输给了机器人。

当时加里·卡斯帕罗夫输掉了一场与一台名为“Deep Blue”IBM电脑的比赛。但在李世石失败之前,围棋的复杂性使它对机械的突破产生了抵制,所以对于人工智能研究人员来说,围棋成为了一个顶级的目标。

然而AlphaGo的胜利之所以能引起重大的关注,是因为这一胜利展示了新型人工智能的力量。这种新人工智能的目标是能让计算机依靠自学解决复杂的任务。

AlphaGo通过研究数千场专业人类围棋选手之间的比赛来学习围棋。从这些游戏中提取规则和策略,然后再在数百万场对决自己的比赛中进行精炼,这足以使它比任何人类玩家都强大。

但构建AlphaGo的DeepMind的研究人员相信,他们还可以继续改进此程序。在刚刚发表在《自然》杂志上的一篇论文中,他们公布了最新版本的AlphaGo Zero。它在游戏中表现得更好,学习的速度更快,而且减少了需要的计算硬件。但最重要与原始版本不同的是,AlphaGo Zero成功地在不学习人类围棋专家的情况下自学了这款游戏。

人类专家往往专注于在更高层次上理解游戏,然而围棋的简单规则产生了大量的新兴结构。玩家们经常谈论一些诸如“眼睛”和“梯子”之类的特征,以及“威胁”和“生死攸关”之类的概念。

尽管人类玩家可以理解这样的概念,用超越文字的方式来对计算机解释这些并且编程却更加困难。

最初的AlphaGo通过研究数千种人类游戏的例子来学习这些概念,这种过程被称为“监督学习”。由于人类的游戏反映了人类对这些概念的理解,一个接触到足够多资料的计算机也能理解这些概念。

一旦AlphaGo在人类教师的帮助下,对战术和策略有了很好的掌握,它就能自己进行成千上万场无人监督的训练游戏,并通过每一场来改进。

监督学习是人工智能许多进步背后的基本思想,包括帮助计算机学会在图像中识别人脸,准确地识别语言,有效地过滤电子邮件中的垃圾信息等等。但Deepmind的创始人戴密斯·哈萨比斯 认为,监督学习是有限度的:由于提供给计算机的信息必须由人类专家筛选,就会对计算机的能力造成限制,无法突破人类的能力。

AlphaGo Zero的设计是为了避免这些问题,因为它完全跳过了初期训练的阶段。这个项目只在游戏规则和“奖励功能”的基础上开始,也就是当计算机取得胜利便得到一分,可如果失败,也将被扣除一分。这种情况可以鼓励计算机反复进行实验,尽可能赢得比赛来得到更多的奖励。

此程序最初开始时,计算机只是无目的性地随机放置棋子。但仅仅过了一天,AlphaGo Zero就已经达到了高级专业围棋选手的水平。两天后,它的表现超过了2016年击败李世石的最初版本。

DeepMind的研究人员眼看着他们的创造重新发现了人类几千年来积累的围棋知识。有时候,它的行为甚至有些像人。经过大约3个小时的训练,这个程序开始专注于贪婪地捕捉棋子——这是大多数人类初学者也会经历的阶段。

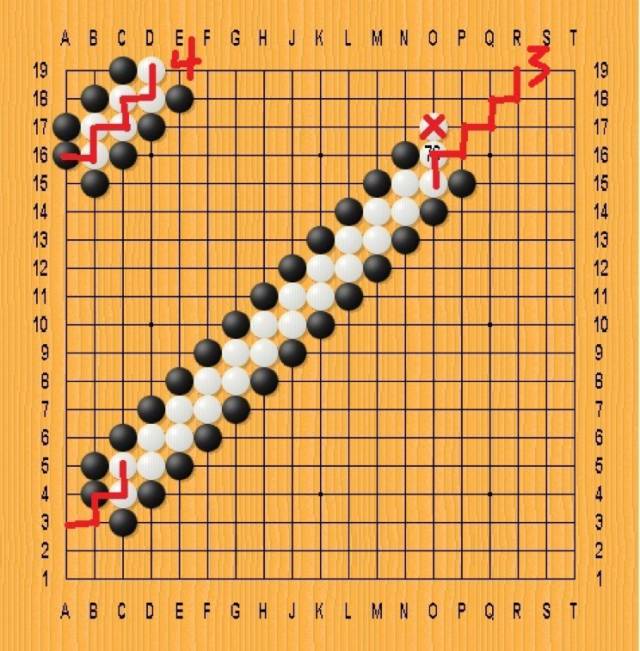

可在另一些角度上,它依然是来源一台机器。例如,“梯子”是在棋盘上的斜线斜杠上延伸的棋子图案,当一个玩家试图捕捉他对手的一组棋子时。 人类新手很快就学会了推断他们,并计算出如果建立一个特殊的“梯子”是否会成功。但是,AlphaGo从零开始,并没有能力进行外推,而是采用了半随机的新动作——比预想的花了更长时间来掌握这个概念。

当然,生活中还有比围棋更多的东西。AlphaGo的创始人希望像AlphaGo这样的算法概论,可以应用于其他类似的任务。比如任何可以通过大量智能搜索的项目,都可以从AlphaGo的方法中获益。他列举了一些经典的棘手问题,比如研究蛋白质如何折叠成最终的功能形状,预测哪些分子可能有作为药物的承诺,或者准确地模拟化学反应。

人工智能的进步经常引发人们对人类退化的担忧。DeepMind希望这样的机器能够成为人类的助手,而不是像其他技术成为人类的替代品。毕竟,看着机器发明解决问题的新方法,可以帮助人们开发新的创造路径。

西尔弗说,AlphaGo的一个好处是,在一场充满历史和传统的游戏中,它鼓励人类玩家质疑古老的智慧,并进行实验。在输给AlphaGo之后,柯洁研究了电脑的动作,寻找灵感。随后,他又以22连胜的成绩战胜了对手,这是一项令人印象深刻的壮举。

小编有补充:

就在2017年10月25日,机器人Sophia被授予沙特国籍,成为首个拥有公民身份的人工智能。Sophia的设计制造公司Hanson Robotics还表示,明年年中以后就可以开始进行量产。

Sophia在大会上 图片来自华尔街见闻

文:The Economist

译:Claire

编辑:Melody

排版:好贼

资料来源:https://www.economist.com/news/science-and-technology/21730391-learning-play-go-only-start-latest-ai-can-work-things-out-without

评论