文|知社学术圈

近年来,机器学习得到了人们的广泛关注,帮助人们从日常生活中产生的大数据中提取有用的信息。在边缘端(如移动设备)部署高速、低功耗的人工智能芯片日益成为一种必需。由于摩尔定律已走向终点,同时由于经典计算机中通讯瓶颈的存在,传统硅基计算系统已难以满足这些需求。因此,开拓新的计算概念、发展新的计算架构和器件来加速机器学习,已成为一个明显的技术趋势。

最近,发表在Science Advances上的一篇论文中,作者们利用基于阻变存储器阵列的存内计算技术,实现了一步训练传统的机器学习算法,包括线性回归、逻辑回归。这一技术可以进一步用于训练多项式回归、神经网络等其它机器学习算法。

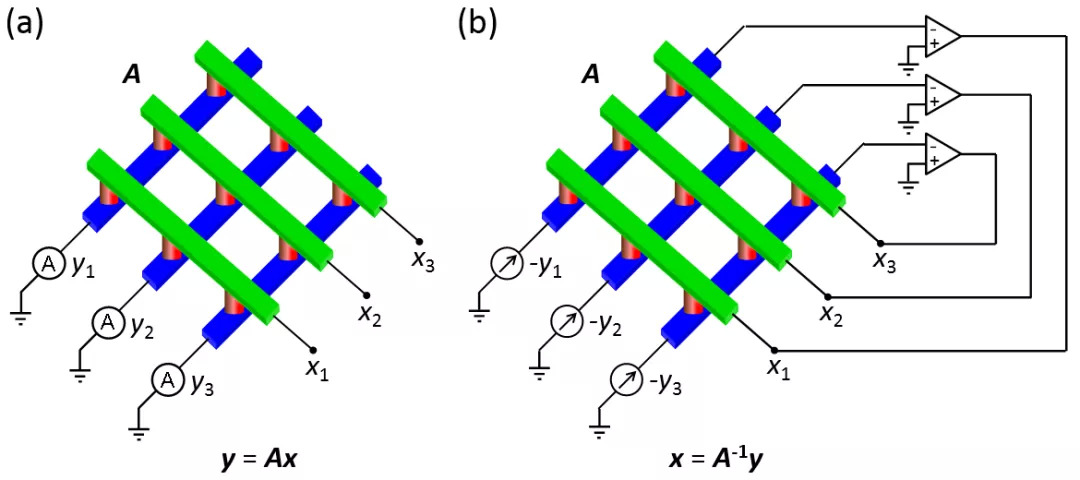

阻变存储器(又称忆阻器)是一种新型的非易失性存储技术。不同于传统的电荷型存储器,它利用器件的电阻这一物理属性进行存储。除了用于二值存储,利用器件电阻的连续可调性,它还可实现模拟存储。阻变存储器一般采用交叉阵列架构,以达到最大的存储密度。基于这一存储架构,人们可以轻易地实现存内计算,加速矩阵-向量乘法的运算(图1a)。矩阵-向量乘法是诸多数据密集型计算任务(如神经网络训练及推理、信号和图像处理)的核心操作,因此,基于阻变存储器阵列的存内计算具有显著的应用潜力。通过构建一个反馈电路,阻变存储器阵列还可以用于一步求解线性方程组(图1b),在数值模拟、统计分析等领域具有广泛的应用前景。

图1. (a)矩阵-向量乘法. (b)解线性方程组.

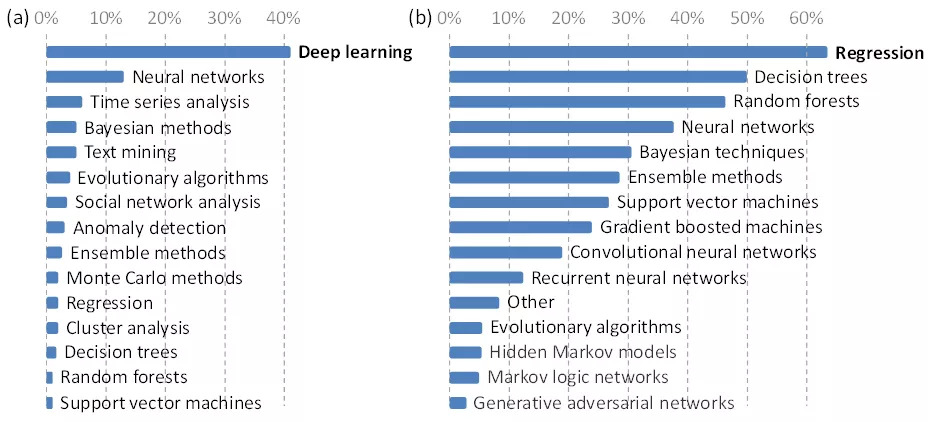

目前,最令人激动的机器学习算法当属深度学习,这也是2017年一份针对数据科学和机器学习的调查结果(图2a)。但是,最令人激动并不意味着应用最广。事实上,调查结果显示,线性回归、逻辑回归是被应用得最多的机器学习算法(图2b)。机器学习算法的训练一般通过迭代计算完成,如反复执行包括矩阵乘法在内的运算,最终收敛到一个最优解。因此,基于阻变存储器阵列的矩阵-向量乘法也被用来加速机器学习。但是,迭代意味着计算缓慢,同时带来巨大能耗。在这篇论文中,作者们提出一个存内计算电路,实现一步训练线性回归、逻辑回归等机器学习算法,无需迭代,从而显著提升计算速度、降低能耗。

图2. (a)最令人激动的机器学习算法. (b)应用最广的机器学习算法.数据来自Kaggle.

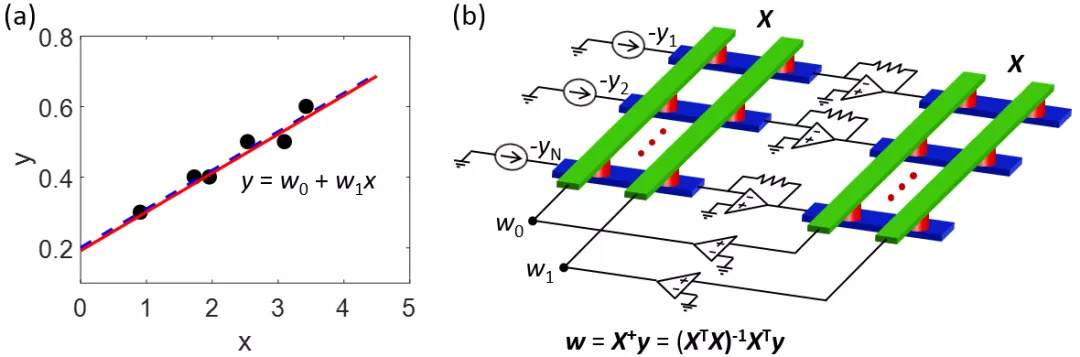

线性回归指的是,存在一系列数据点,要找到一条最好的拟合直线,使数据点与直线之间的误差最小(图3a)。线性回归被广泛应用于生物学、经济学等领域的归纳、预测分析。为了使拟合误差最小,拟合系数存在一个伪逆解,它的具体形式见图3b。为了得到这一解,作者们利用阻变存储器阵列构建了一个反馈电路(图3b)。在这个电路中,包含所有数据点的自变量值在内的矩阵X存储在两个相同的阻变存储器阵列中,而相应的因变量值构成的向量y作为电路的输入电流。该电路自动完成线性回归的计算,正反馈运放的输出电压即为拟合系数向量w。针对图3a中的数据点,电路实验中得到的拟合直线和理想解高度一致,证明了该电路用于一步训练线性回归模型。

图3. 线性回归及相应的存内计算电路.矩阵X+是X的伪逆.

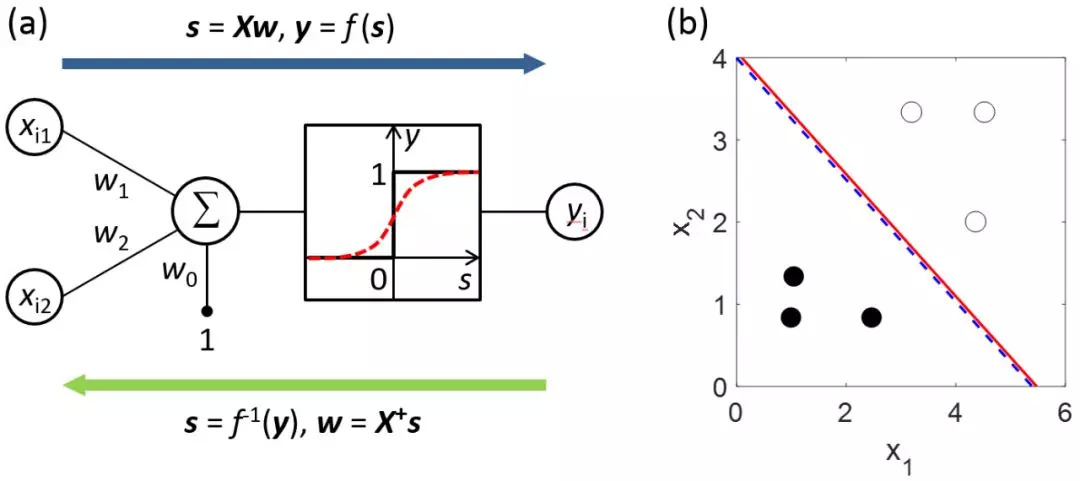

逻辑回归被广泛用于模式识别和分类任务,如简单的垃圾邮件识别,或作为深度神经网络的最后一层分类层。线性回归是一个纯粹的线性模型,而逻辑回归还包含了一个非线性函数来产生二值输出,它可被看作一个单层前馈神经网络(图4a)。为了训练这个模型,可以先利用非线性函数的逆函数,将样本的标签值转化为输入的线性加和值,从而问题退化为简单的线性回归。因此,作者们所构建的存内计算电路也可用于训练逻辑回归。在图4b中,实验中得到的分类结果和理想结果十分接近,进一步验证了该电路的机器学习功能。

图4. 逻辑回归.

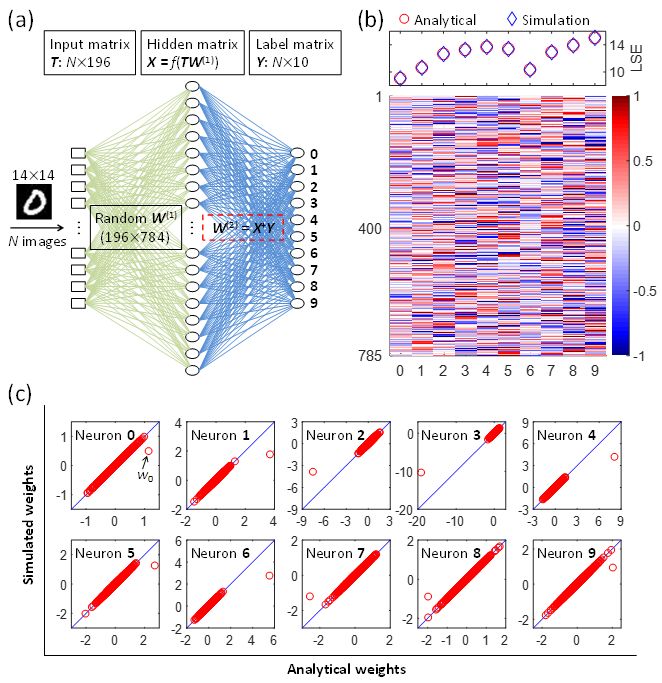

为了支持该电路的可扩展性,作者们利用Boston housing数据集训练了一个更大的线性回归模型。在该模型中,阻变存储器阵列的规模是333×14,仿真的拟合系数和理想结果之间的误差低于1%,回归及预测结果也接近最小误差,从而证明了该电路实际应用的可行性。此外,作者们还利用该电路训练了一个两层的神经网络,用于MNIST数字识别。图5中,仿真训练的权值和理想结果高度一致。当利用训练的权值识别数字测试集时,识别率和理想值相同。具体内容详见论文。这些结果显示,由于其高速计算的性能,存内计算在加速机器学习方面具有巨大潜力,有力地支撑其应用于边缘端的人工智能芯片。

图5. 利用存内计算电路训练一个两层的神经网络.

论文于最近发表在Science Advances上,其作者们来自米兰理工大学。在该论文之前,他们于2019年在《PNAS》上发表了一篇论文,提出了一个存内计算电路,实现一步解线性方程组,其时间复杂度优于量子计算。论文的第一作者孙仲博士毕业于清华大学,在结束博士后工作后,将于今年春季学期加入北京大学黄如院士领导的团队,任研究员、博导,欢迎年轻学子们、博士后加入团队一起工作。

评论