文|AI报道

上一次英伟达发布“地表最强AI芯片”Tesla V100还是在2017年。尽管过去三年,不断有对手放话称性能超越V100,迄今V100仍是最频繁出现在各家云端AI芯片PPT上的公认性能标杆。

2月26日,Twitter用户KittyCorgi发表了关于英伟达新一代Ampere GPU的传言推文,他表示,英伟达新一代Ampere GPU提升幅度将近70%,并且RTX(光线追踪)性能将会有翻倍提升。当时有评论指出,如果传言成真,那么Ampere GPU的性能将以碾压性优势击败AMD在2020年即将推出的所有GPU。

5月14日晚,英伟达CEO 黄仁勋以“在家里的厨房提前录制了演讲视频”的有趣方式石锤了这则传言,全新基于安培架构的专业级GPU——A100性能比V100提升20倍!在AI训练这件事上,一片可顶过去六片。

首款Ampere架构GPU问世

Ampere是英伟达继2018发布的Turing(图灵)架构之后的最新一代GPU架构,也是英伟达推出的第八代GPU架构。

据介绍,最新的A100 GPU集成了超过540亿个晶体管,这使它获得“全球最大尺寸”的7nm制程处理器的称号。

如此高的集成度已经达到了现今半导体工艺的极限,黄仁勋表示,“Ampere架构的突破性设计为英伟达第八代GPU提供了迄今为止最大的性能飞跃,集AI训练和推理于一身,并且其性能相比于前代产品提升了高达20倍。这是有史以来首次,可以在一个平台上实现对横向扩展以及纵向扩展的负载的加速。A100将在提高吞吐量的同时,降低数据中心的成本。”

A100是人类有史以来生产过的最大的处理器内核,也是人类有史以来集成度最高的计算机处理器。除此之外,A100还有另外四大关键特性:

1.具有TF32的第三代 Tensor Core核心,英伟达广泛采用的 Tensor Core核心现在已变得更加灵活、快速且易于使用,能更好地处理AI运算中的稀疏张量。

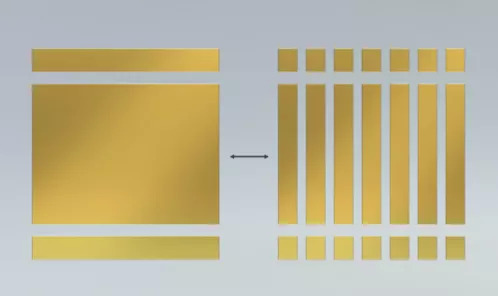

2.多实例GPU-MG,一种全新技术功能,可将单个A100GPU分割为多达七个独立的GPU,为不同规模的工作提供不同的计算力,以此实现最佳利用率和投资回报率的最大化。

3.第三代 NVIDIA NVLInk,使GPU之间的高速联接增加至原来的两倍,实现服务器的高效性能扩展。

4.结构化稀疏,这种全新效率技术利用AI数学固有的稀疏性,使性能提升了一倍。加入对稀疏张量的优化后,A100在FP16精度上的算力是V100的5倍,而在INT8上则提升了200倍。

值得一提的是,英伟达将把A100应用到堆栈AI系统。这个全新的堆栈AI系统叫DGX A100,集成了8块A100,因一个机架可比肩整个AI数据中心而被称为“全球最先进AI系统”。

多实例GPU-MG的全新技术功能,可将单个A100GPU分割为多达七个独立的GPU,对DGX A100实现精准“切蛋糕”。也就是说,使用DGX A100系统的研究人员和科学家可以将任务拆分成多达56个实例,将众多小规模任务分散在强大的GPU上。

对此,黄仁勋算了一笔账:一个典型的AI数据中心有50个DGX-1系统用于AI训练,600个CPU系统用于AI推理,需用25个机架,消耗630kW功率,成本逾1100万美元。而完成同样的工作,一个由5个DGX A100系统组成的机架,达到相同的性能要求,只用1个机架,消耗28kW功率,花费约100万美元。

这样一算,正应了黄仁勋的名言:“买得越多,省得越多”。DGX A100系统用一个机架,就能以1/10的成本、1/20的功率、1/25的空间取代一整个AI数据中心。

目前,DGX A100系统已经开始发售,首先将应用在美国阿贡国家实验室对COVID-19新冠病毒的研究中。黄仁勋说:“DGX A100系统的算力将帮助研究人员探索治疗方法和疫苗,并研究病毒的传播,使科学家能够在数月或数日内完成数年的AI加速工作。”

除了科研机构外,英伟达表示,微软、亚马逊、谷歌、阿里、百度、腾讯、浪潮、联想等大型云服务提供商计划将A100 整合到自己的产品中。

巩固GPUAI训练标配地位

GPU,即图像处理单元,起初是专门面向图像处理,主要应用在游戏及图像软件方面。如今,趁着AI市场的崛起,GPU已经被广泛应用在AI各大应用场景,尤其在机器学习、深度学习的算法训练中,几乎成为标配。

GPU是一个可以利用多个线程来进行高速的矩阵运算,而深度学习中会涉及到很多的矩阵运算。这也正是GPU在AI领域的用武之地。但此前,深度学习对于运算量的要求很高,但是对计算精度的要求不高,因而对于GPU的要求也没那么高。这也是没人会想到GPU能火起来的原因之一。

A100融合了AI的训练与推理于一身,并且其性能相比于前代产品提升了高达20倍、可以在一个平台上实现对横向扩展以及纵向扩展的负载的加速,在提高吞吐量的同时降低数据中心的成本,从而实现“降本增效”。正如上文所说,DGX A100系统用一个机架,就能以1/10的成本、1/20的功率、1/25的空间取代一整个AI数据中心。

此外,英伟达的GPU几乎是目前高端服务器,尤其是AI服务器的“标配”。这意味着,英伟达的A100 GPU不仅能够让数据中心的性能“飞起来”,还能够极大地降低AI研发的成本、行业的成本,从而促进AI产业的发展。

黄仁勋称:“云计算和 AI 的强大趋势正在推动数据中心设计的结构性转变,过去的纯 CPU 服务器正在被高效的加速计算基础架构所取代。A100 GPU 作为 一个端到端的机器学习加速器,其实现了从数据分析到训练再到推理 20 倍的 AI 性能飞跃。这是有史以来首次可以在一个平台上实现对横向扩展以及纵向扩展的负载的加速。”

另外,对于英伟达而言,基于Ampere架构的灵活性以及产品的灵活组合,不仅能够更好实现训练和推理性能的提升,也更有助于英伟达打造云端和边缘端一体化的AI产品,保持在AI市场的竞争力。

例如,在云端市场,英伟达用A100同时满足训练和推理需求,这将在云端AI推理芯片市场占有优势的英特尔带来更大的竞争压力,而想要挑战云端芯片市场的AI芯片的初创公司难度也进一步升级;在边缘市场,英伟达用高性能、多产品组合去满足市场丰富的应用需求,持续开拓生态,要将云端的优势拓展至边缘端。

NVIDIA全球副总裁、PSG兼云计算业务中国区总经理Ashok Pandey曾表示:“GPU计算正在加速着深度学习革命。”在Pandey看来,NVIDIA在GPU计算或者说深度学习领域已经形成了完整的平台,“并通过这个平台让更多的合作伙伴实现了业务交互,形成了产业链发展。”

芯片国产替代的窗口期

芯片一贯被誉为科技巨人头上的“皇冠”。当“新基建”成为新一轮的“风口”时,芯片产业发展也已迎来新的机遇。

5月7日消息,IC Insights发布2020年第一季度全球销售额排名前十的半导体(IC和OSD光电、传感器和分立器件)供应商。其中,英特尔、三星、台积电位居前三,而华为海思首次跻身前十,位列第十名。

在依托华为海思的芯片设计能力的同时,也与其专供华为手机有关,并且由于疫情,高通等厂商销量遭受打击,这才让海思能够获得迎头追赶的机会。然而,尽管如此,国内GPU技术仍然落后。2018年,华为曾推出过GPU Turbo技术,但只是通过修改软件底层代码提高GPU效能,并不是完全的自主研发。因为,英伟达在这一领域,几乎实现了行业垄断。

不过,针对GPU的垄断,各大厂商都在寻找“弯道超车”的机会。目前,AI芯片的构架和种类繁多,由于专门用于AI训练和决策,对于芯片的要求并不高。例如,由赛灵思、Altera(英特尔)主导的FPGA,以及以谷歌TPU为代表的ASIC等新构架已经崛起。尤其是ASIC由于其门槛低、可定制等特点,受到各大AI芯片厂商的青睐。国外的高通、英特尔,国内的华为海思、寒武纪、地平线、云知声、阿里达摩院、中星微等厂商的AI芯片均基于ASIC,对GPU形成了强有力的挑战。

因此,尽管目前国产芯片的研发和设计技术仍然有待提高,但在众多应用场景的倒逼下,已经取得了显著的成绩。其中,华为海思、寒武纪、阿里达摩院等厂商的崛起就是最好的例证。

面对科技的快速发展和变化,谁都无法确保自己绝对领先的地位。即使是英伟达,也曾在矿机芯片上的押错宝,因此很难断定其能否始终在AI芯片上一骑绝尘。而以往GPU并非专为AI而设计,英伟达只是在适当的时机抓住了风口罢了。

此次英伟达再次以重量级产品“秀出了肌肉”,令人惊叹其技术的同时,也透露出一丝危机感。毕竟其身后还有大批追赶着,不仅是传统芯片厂商,还有不少科技巨头、初创企业,甚至有应用层厂商正虎视眈眈。

那么,英伟达能否继续独霸下一个万亿芯片市场?

期待未来芯片行业的好戏上演。

评论