文|新智元

编辑|金磊

DeepFake的克星,来了!

自从DeepFake诞生以来,从照片到视频,造假能力可谓是出神入化,人们惊呼:“再也不敢相信自己的眼睛了。”由此所带来的道德伦理与法律的影响也可见一斑。

针对这一现象,来自加州大学河滨分校的研究人员最近便提出了一种基于神经网络的神器,分分钟鉴别照片真伪!

该算法的初始测试从未经修改的图像到单个像素级的假图像,其准确率在71%到95%之间,具体取决于使用的样本数据集。

该算法还没有扩展到包含对深度假视频的检测。

DeepFake是把双刃剑,或成威胁社交媒体时代的新工具

加州大学河滨分校电子与计算机工程学教授Amit Roy-Chowdhury表示:

“DeepFake是经过修改的图片或者视频,可以向其中插入或删除一部分内容,这就改变了图片原来的含义。”

鉴别DeepFake的真伪在科研中可以说是一种挑战,而这种挑战的出现是因为它以一种人类肉眼无法分辨的方式被操纵着。

而在目前经济、社会快速发展的大背景下,无论是人道主义、产品发布或是竞选活动等方面,DeepFake的视频和图像可能会导致事情发展结果的黑白颠倒。

试想一下,若是DeepFake技术被广泛恶意使用,那么我们可能会经常看见某位政治候选人涉嫌实施暴力犯罪、某位CEO承认其公司产品存在安全问题等等扰乱社会平稳发展的事情。

Chowdhury是这项研究的五位作者之一,他表示:

这种检测算法可能是对抗社交媒体时代新威胁的有力工具。不过大家也需要注意不要过度依赖这些算法。过度可信的检测算法可能被那些试图传播虚假信息的人武器化。

我认为我们必须小心处理与AI和机器学习有关的任何事情,我们需要了解这些系统给出的结果是概率性的。并且这些概率通常不在0.98或0.99的范围内,恰恰远低于此。我们不应该盲目接受它们。

从这个意义上讲,DeepFake实际上只是网络安全中的一个新领域,网络安全是一场永远的军备赛,“好人”和“坏人”都在不断进步。

在这项研究中,工作人员利用当前文献中已有的概念,将它们以一种新颖而又强大的方式结合起来。

只要两步算法,DeepFake图像无影遁形

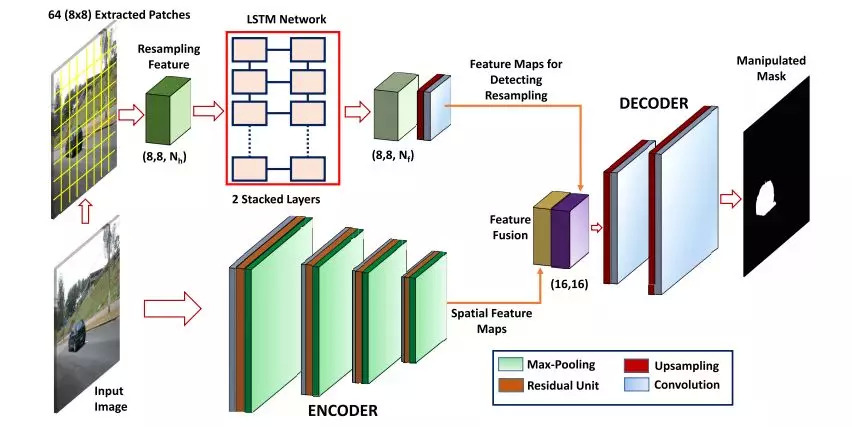

这个算法其中一个组成部分就是递归神经网络,它将问题中的图像分成小块(patch),然后逐个像素地去观察这些小块。

算法结构框架

神经网络已经在成千上万张深度伪造以及真实图像中进行了训练,因此它已经学会了如何在单个像素级别中凸显伪造痕迹。

Roy-Chowdhury表示,图像被篡改部分周围的边界往往包含着操作的痕迹。图像在被插入物体时,边界区域往往具有一定的特征。

而那些故意篡改图像的人会额外在物体边缘区域下功夫,搞得过于平滑,争取让算法提取不出特征来。

算法的另一部分就是通过一系列编码过滤器传递整个图像。从数学意义上讲,这些过滤器能够使算法在更大、更全面的层次上考虑整个图像的情况。

然后,这个算法就会把从逐个像素输出的结果和更高层次的编码滤波器分析结果进行比对。当这些并行分析在图像的同一区域触发红色标记时,就会被标记为“可能是DeepFake”。

假如,一只小鸟的图像粘贴到了原本只有树枝的图像(如下图所示)。

在这种情况下,逐像素(pixel-by-pixel)算法可能会将鸟爪周围的像素标记为“有问题”。而编码器算法可能会在更大的层次上,例如其他边界问题或更大尺度级别的异常。

只要这两种神经网络标记处鸟周围图像的同一区域,Roy-Chowdhury团队的算法就会把鸟和树枝的照片归类为“可能是DeepFake”。

下一步,DeepFake视频也将“在劫难逃”

DeepFake的图像目前已然能够鉴别真伪,那么下一步就是视频了。

Roy-Chowdhury表示现在需要对算法做一个扩展,并应用到视频中。这种算法可能需要考虑图像如何逐帧变化,以及能否从变化中及时识别出任何可检测的模式。

鉴于DeepFake检测的紧迫性,以及随着世界各地越来越多不怀好意的人试图利用这种虚假信息作恶。Roy-Chowdhury呼吁其他研究人员能够利用他们的算法在更真实的环境中做检测。

评论