文|阿尔法工场

这个春天,Sora几乎成了统治整个AI圈的“刷屏王者”。

这个由OpenAI推出的AI视频生成神器,凭借其惊人的创造力,让人们再次见识到了AI的无限可能。而这炸裂的能力背后,蕴含着的是指数级的财富增量。

Sora发布后,OpenAI的估值一夜之间涨到了800亿美元。

在内容消费升级的大背景下,AI视频生成技术,正成为资本市场的新宠。

在此热潮下,一大批立志追赶或效仿Sora的国产AI企业也乘势而起。其中,七火山科技算是步伐较快的一个。

作为一家专注于AI多模态应用的企业,七火山旗下的产品包括了Lava AI视频编辑平台,Bromo AI图像处理工具等,旨在为用户提供AI换脸、AI换背景和AI优化视频等功能,可以说在AI视频领域,七火山早有布局。

Sora公布后,七火山很快紧随其后,发布了自身号称国产版“Sora”的文生视频大模型——Etna。并宣称其以“4K” 、“60帧”、“15秒”等硬性指标,打破了国内文生视频AI的各种纪录。

那么,在多个耀眼的标签下,这个国产版“Sora”,成色究竟怎样?

01 导演VS剪辑师

如果用一句话来评价Sora和Etna之间的差距,那么Sora更像是一个全能的导演,而Etna则像是一个专业的视频编辑师。

要理解这点,我们就得从技术上拿捏一下Etna的“看家本领”。

按照七火山目前披露的信息,Etna主要的特色和优势分别是:

1、高帧率(每秒60帧);

2、高分辨率(可以达到4k);

3、较长的视频时长(8—15秒),讲真,这个时长在国内文生视频AI里(大部分是3~4秒)算不错的了。

实事求是地说,在帧数和分辨率方面,Etna已经超越了目前Sora。因为现在Sora仅仅只能生成帧数为每秒30帧,分辨率为720p的视频。

然而,以上几点仅仅是Etna的“皮相”,真正决定其与Sora差距的,还是Etna自身的底层架构。

不过话说回来,即使是在“皮相”的部分,Etna和Sora也存在着一些肉眼可见的差距。

例如从整体上看,Etna生成的视频,大部分都是一些运动幅度较小的片段,看上去更像是一些加了动效的PPT。(关于这部分原因,后面会分析)

从底层架构上来说,虽然Etna和Sora采用的都是Diffusion+Transform架构,但Etna较为不同的地方,就是在此基础上插入了时空卷积和注意力层。

这样做的一个好处就在于,与Transformer相比,CNN在处理高分辨率视频时更高效,并且有助于减少计算资源和内存的需求。

这正是主打4K分辨率的Etna所需要的。

然而,问题就在于,在处理长视频(1分钟以上)时,卷积神经网络(CNN)可能会受到限制,因为传统的CNN在处理极长序列时可能不如Transformer有效。

这主要是因为,Transformer通过自注意力机制来处理序列数据,而CNN往往将视频视为一系列独立的图像帧,然后分别逐帧处理。

其中的区别,就相当于Transformer是一本超级详细的日记,它可以让你随时查看任何一页,而且每一页都记录了这部电影的所有细节,包括画面与画面之间的所有联系和变化。不管你想回忆起电影的哪个部分,它都能帮你找到,并且告诉你前因后果。

而就CNN是好像相册一样的东西,它只能一次给你看几张照片,而且它看的照片是按照一定的顺序排列的。

但是当你想回忆起一个很早之前的画面和后面的画面之间的联系时,它可能就帮不上太大的忙了。

这等于是,Etna为追求更高的分辨率和帧数,舍去了生成更长视频的可能。

从算力上来说,这其实也是一件情理之中的事,毕竟,在生成长视频的同时,还要保持极高的分辨率和帧数,这消耗的计算资源,即使是OpenAI也顶不住。

这也是为什么Sora目前只能生成每秒30帧,分辨率为720p的视频。

但问题是,Etna为什么要做这样的取舍?

这里有三种可能:

一是七火山本身的计算资源、底层技术不到家,所以只好用时空卷积+注意力层的办法,让视频在较短的时间内,勉强让画面“动”起来;

二是七火山的商业模式,决定了它不会走长视频的道路,也就不会去钻研这方面的技术;

第三种情况,就是两者兼而有之。

02 参天大树和盆景

AI生成视频,尤其是长视频,对计算资源的消耗是惊人的。

之前OpenAI的CTO在接受采访时,就明确表示,虽然Sora会在今年晚些时候推出,但由于高昂的计算资源,其价格“可能会很贵”。

就目前国内AI行业愈发谨慎的投资环境来说,能否说服VC或投资人,给这么一个比LLM(大语言模型)更烧钱的技术融资,要打一个大大的问号。

而商业路径最明确,“回血”也最快的短视频赛道,就成了视频生成类AI最有可能被资本认可的方向。

这种商业上的考量,或许正是Etna在架构层面没有往长视频方向发展的原因。

再者,从技术方面来说,虽然Etna采用了与Sora类似的Diffusion+Transform架构,但这绝不意味着,任何一家公司,只要对着这个架构照抄,就能做出和Sora一样好的视频。

换句话说,Sora在生成质量上的亮眼表现,其实更像是一种工艺上的精进,而非掌握了某种“秘术”。

如果说得稍微具体些,这种“工艺”上的精髓,很有可能就是Sora在多模态理解和长距离依赖方面的优势。

这样的区别,决定了模型能否理解用户给出的复杂指令,能否生成一些动作幅度较大、或者较为复杂的片段。

能做到这点的模型,就是“导演”,否则就只能当个“剪辑师”。

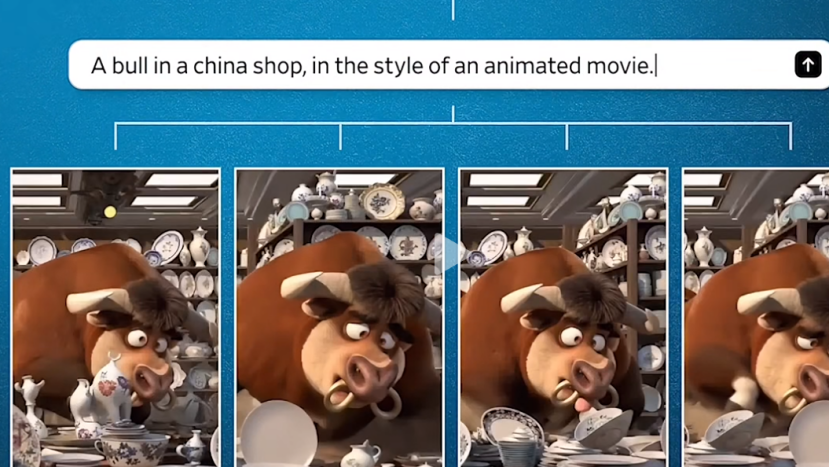

举例来说,Sora这个“全能导演”不仅仅是能根据文字来生成视频,它还能理解文字里的复杂情节和细节,然后自己想象出一整套画面来。

例如前段时间,Sora公布的一段视频中,就出现了“一个男人参拜巨型猫王”的片段。画面的提示词是:座巨大的大教堂里全是猫。一个男人走进大教堂,向坐在王座上的巨型猫王鞠躬。

在整个视频中,画面所透出的“故事感”特别强烈,即使没有旁白,观众也能自行脑补一系列情节。

而到视频的末尾,猫王甚至还凑到男人面前嗅了嗅,仿佛是在“打量”这个参拜者。

如此复杂的画面和动作,需要模型在多模态理解方面有很强的功力。

而Etna在对其进行效仿时,可能由于并未掌握其精髓,或是由于计算资源不足的原因,采用了时空卷积+注意力层的办法,作为一种“权宜之计”,让视频勉强“动”起来。

这也是为什么,Etna生成的视频,大部分都是一些运动幅度较小的片段。

因为这样的片段往往比较简单,不太涉及对复杂语义的理解,消耗的算力资源也比较小。

话说回来,Etna之所以在架构中采用时空卷积+注意力层,最有可能的原因,就是二者在计算效上率相较于单纯的Transformer架构更高效,对算力要求更小。

因为时空卷积和注意力层在处理数据时,通常只考虑局部信息,而不需要考虑整个序列。

这其实也挺符合七火山现在的短视频战略的,毕竟短视频追求的就是一个“短、平、快”,如果有可能的话,最好能把算力的要求,降低到大部分手机都能运行的地步。

如此一来,随拍随发,用户才能用得尽兴,应用的粘性才够强。

七火山和快手海外 SnackVideo 也有合作

不过,这种看似“高效”的策略,总不免透着些遗憾。

毕竟,Sora这类的“导演”级模型,虽然很难造就,但其前景和应用方向,无疑是更加广阔的。之后无论是电影、电视剧,甚至是机器人、自动驾驶训练所需的模拟视频,都能让其大展拳脚。

而相较之下,专精于短视频的Etna,虽然也可以成为一个很好的“剪辑师”,但视频AI的想象力,难道就该仅仅止步于短视频吗?

这就像是,虽然盆栽确实可以长得很精致,但只有参天大树,才能见到更广阔的天地。

评论