文 | 雅斯顿 默默

许多消费者认为只有当无人驾驶做到「绝对安全」时才能被广泛应用,甚至进入法律。关于这一点,之前有文章已经提到,无人驾驶更切合实际的标准应该是比人类驾驶水平足够优秀即可,因为无人驾驶不可能做到「绝对安全」。

1「绝对安全」的误解

如果认为「无人驾驶」需要做到绝对安全才能被写进律法,那么可以断定「无人驾驶」永远不会取得合法地位,因为时至今日尚没有一款操作系统或者硬件可以保证完全零失误。即便有企业发布声明表示,自己的操作系统和硬件可以做到零失误,也只是基于当下的科技发展水平。

如今,操作系统为了确保功能和稳定,已经变得越来越庞大,一款早期的windows系统,大概有500万行代码,如今这一数量已经进化到千万级,如此庞大的代码数量不可能出现失误,即便是正常运行遇到外界干扰也不容易出现故障。

当然,增加备用系统是一套不错的解决方法,即当一款系统出现故障时,另一套备用方案立即启动,这是一套切实可行的办法,在不计较成本投入的前提下,软件层面的失误可以降低大部分。

只是,操作系统软件层面的失误本就不是大多数,导致系统崩溃70%的原因来自驱动,这些驱动是软件和硬件之间连接的桥梁。一旦驱动发生失误,整个系统运行会迅速崩溃,或者丧失对某个硬件的控制能力,这在无人驾驶中是极其危险的。基于系统的庞大,我们几乎无法预测将要出现的失误。

既然无法达到「绝对安全」,我们又该如何针对「无人驾驶」进行安全评级呢?虽然之前提及,智能机器驾驶汽车只需要高于人类驾驶水平即可,但问题是该如何衡量人类的驾驶水平,智能机器的驾驶水平又需要高到何种程度才能被消费者接受?

2 量化「无人驾驶」的安全水平

「无人驾驶」的驾驶水平一定要高于人类,即便只是和人类驾驶水平相当也不能取得人类的认可。

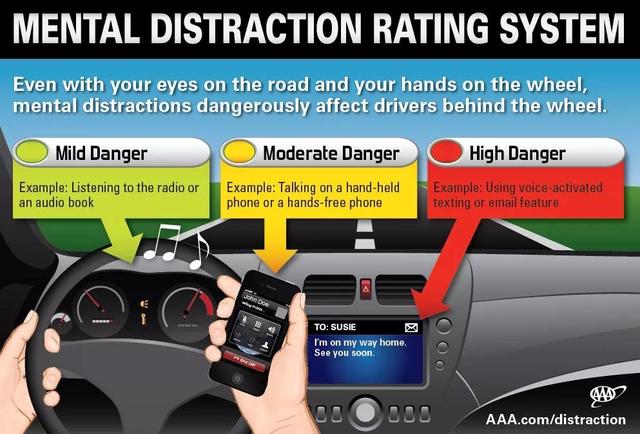

在人类看来,一个普通人驾驶车辆由于疲劳、醉酒等等原因导致的车祸,可以迅速的「被原谅」,仅仅因为事故原因简单明了,责任明确,只要强加约束人类不良行为习惯即可。当「无人驾驶汽车」发生事故时,并不会被原谅,反而会引起整个社会的公愤,原因在于事故原因不可预测,消费者只会将原因归于「无人驾驶」的不可靠。

如果为「无人驾驶」汽车的安全性制定一条安全基准,这条基准可以来自汽车保险行业数据,比如美国的汽车驾驶员每17年就会有一次事故,或者每个驾驶员每20万公里就会申请一次保险理赔,这个数据仅作为人类驾驶水平的参考,但却可以对无人驾驶的安全性进行量化。

如果将「无人驾驶」水平设定为人类驾驶驾驶水平的两倍,那也就意味着「无人驾驶」汽车每40万公里才会出现一次保险理赔,或者每34年才会出现一次事故。针对事故和保险理赔金额再进行更加详细的评级,则很容易得出量化「无人驾驶」驾驶水平的体系。

这样的体系对于消费者来说显然更容易接受,对汽车制造企业来说也更加简单,汽车安全或许会成为所有汽车企业共同参与创建的云数据库。因为对于汽车安全来说,需要不断重复的测试,但这对机器来说就更加简单了。

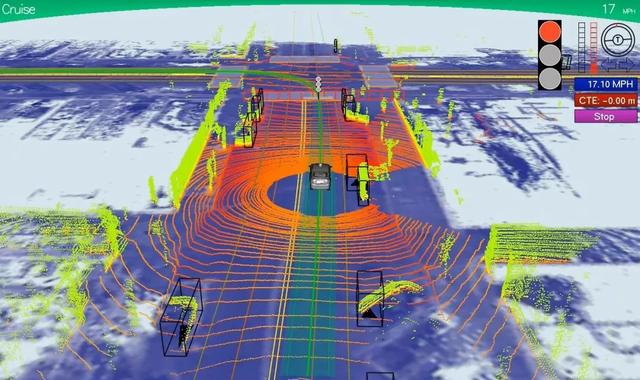

当某辆车在测试过程中遇到了某个特定情况,即可将处理方式上传到云数据库,然后将其复制到其他车型上,甚至在某处刚刚发生了某个稀奇古怪的「无人驾驶汽车事故」,其他车辆同时已经具备了处理类似事故的能力。这是智能机器思考的优势,这种方式被称作「丰巢思维」,就是集体学习,得到幂次方的进化速度。

问题是,不同汽车未来并不会因为拥有相同的云数据,就会具备一致的安全能力,不同价位不同配置的车型依然会拥有不同的安全系数,这种安全系数同样可以以高于人类驾驶水平的能力评价,比如高于人类驾驶水平2倍,3倍或者5倍。

针对于人类驾驶水平2倍的车型,政府可以在软件层面直接限制其极速,以较低的速度保证相对安全,而对于那些安全系数更高的车型,极速可以设计更高一些,保证整个城市的通行效率。

3 民航飞机对无人驾驶的启发

无人驾驶的政府监管则可以借鉴民航飞机数十年来的发展。如今民航飞机每200万次飞行出现一次故障,相比上个世纪50年代大概提升了100倍,而且因为安全性的提升,飞机已经可以更加安全的执行更长时间、更长里程、更快速度的飞行任务了。

这种安全建立在政府对飞行员资质和驾驶水平的严格控制,同时对飞机维护也指定了十分详细法律法规的基础上。对于「无人驾驶」,政府监管也当如此,制定一套合理而透明的机制权衡和量化机器人驾驶员的能力,而且这种监管要深入系统层面。

同样由于系统的不稳定性,美国联邦航空管理局就要求飞机需要高度模块化和冗余设计的操作系统,比如在飞机上关键物理结构需要有双重或者三重的防护设计,比如燃油管路需要双层护套,当内侧油管发生泄漏时,外侧油管不光可以承接泄漏并可以侦测报告。

系统分离也是特别需要注意的地方。过去系统崩溃大都源于一个小细节或者小程序,如今将核心部位的系统分离开发,控制引擎的和控制起落架的软件是完全分离、互不影响的,娱乐系统和空调系统也是相互分离的,这样可以大幅降低系统崩溃的风险。

这些分离的系统之间还需要保持联系,当其中一个系统发生故障,其他程序可以在一定程度上承接,当遇到多个系统反馈不一致时,系统内部可以通过「投票」得到解决方式。

除此之外,无人驾驶所有的线缆和车载电脑应该远离人体,避免人为的故意损坏,同时「无人驾驶」汽车还会被要求安装第三方或者政府机构的监督软件,记录系统的操作过程,以便解决纠纷。

一旦政府对「无人驾驶」汽车确定了全面的监管机制,那么「无人驾驶」汽车的管理就变得顺理成章。政府可以根据车辆用途制定不同的行车规范,比如对承载儿童、学生的校车,政府可要求其安全系数必须达到人类驾驶水平的十倍方可上路,而对更容易造成危险事故的货车、卡车,可以要求其极速降低以及相对较高的安全系数,至于普通轿车则维持一个主流水平,有利于降低消费者购车支出。

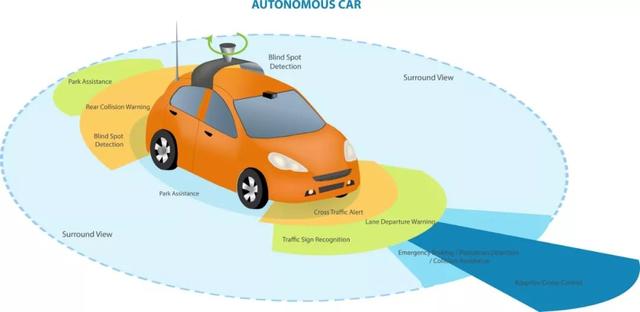

过去,消费者购买汽车大都衡量汽车的动力水平、变速箱匹配,但随着「无人驾驶」汽车的普及,未来消费者的决定因素会逐渐转移到安全系数上,越高的安全系数意味着技术越先进,传感器越复杂等等。

在「无人驾驶」汽车无法做到「绝对安全」的前提下,只需要制定出无人驾驶汽车安全的具体量化指标,同时加大监管,「无人驾驶」汽车便拥有了一个看得见甚至摸得着的清晰目标,如此,「无人驾驶」便可以更迅速的发展。

评论